-

데스크톱에서 공짜 인공지능 모델 사용하기(llama, gemma)카테고리 없음 2024. 8. 14. 22:57

Ollama(https://ollama.com/) 에서 거대 인공지능 모델(LLM)을 자신의 컴퓨터에서 쉽게 돌릴 수 있는 프로그램을 내놓았다.

GPT 모델을 돈 주고 사용하고 있는데 무료로 메타(구 페이스북)에서 배포하는 라마(llama)를 사용할 수 있다니 정말 좋은 세상이다. 그것도 매우 쉽게 .

우선 올라마 사이트에서 다운로드를 받아서 실행을 한다.

출처: 올라마

설치 후 설치를 하고 나면 프로그램이 실행되고 있다.

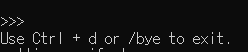

확인을 위해서 cmd 창을 띄워서 ollama를 입력하고 실행한다. 그럼 다음과 같은 메시지가 나온다.

ollama 실행 후 cmd에서 ollama 실행 이 화면이 뜬다면 제대로 설치된 것이 맞다.

그러면 이제 라마 3.1:8b(latest)를 실행하기 위해서는 Model에 들어가서 llama3.1을 클릭한다.

올라마 모델 cmd 명령어 창에 다음과 같이 입력한다.

ollama run llama3.1:8b

llama3.1:8b 글 쓰는 시점에서 가장 최신에 나온 버전이고 4.7gb로 다른 버전에 비해서 매우 가볍다.

llama3.1 다양한 버전 이 글을 쓰면서 ollama를 실행하고 있는데 인터넷 속도가 100bps를 사용하고 있어서 매우 느리게 받고 있다. 거의 다 받은 상황에서 마지막 작업이 매우 느리다.

최종 작업이 끝나면 다음과 같이 메시지가 뜬다.

메시지에 사칙연산을 할 수 있는 파이썬 프로그램을 만들어달라고 해보았다.

나온 결과를 코랩에서 돌려보았다.

정확히 잘 나오고 있다.

gemma를 사용하기 위해서는 글 쓰는 시점에서 가장 최근 버전인 9b를 설치하기 위해서 다음 명령어를 입력한다.

ollama run gemma2:9b같은 방식으로 질문을 하면 된다.

나올 때는 ctrl + c를 눌렀는데 안되고 다음 메시지가 뜬다.

ctrl + d를 누르거나 /bye를 치면 프로그램을 종료할 수 있다.

인터페이스가 매우 개발자스러운 것을 확인할 수 있었다. 이 인터페이스를 사용하기 싫다면 블로그에 가서 사용법을 익혀서 웹페이지를 만드는 방법을 추천한다.

Blog · Ollama

Get up and running with large language models.

ollama.com

주로 파이썬을 사용해서 다음 링크를 통해 파이썬에서 사용하는 방식을 확인할 수 있다.

https://pypi.org/project/ollama/

ollama

The official Python client for Ollama.

pypi.org

자세한 사항은 다음 글에서 이야기 하도록 하겠다.